一个API请求让大模型服务瘫痪!看MAF如何破局LLM供应链漏洞危机

发布时间 2025-12-18前言:

随着大模型成为企业数字化转型的关键组件,其供应链安全问题日益凸显。近期,主流大模型推理引擎vLLM被曝出高危远程代码执行漏洞(CVE-2025-62164),攻击者仅需发送一个恶意构造的API请求,即可导致服务崩溃。这再次揭示了大模型供应链的脆弱性。本文将通过该漏洞分析大模型供应链的安全挑战,并介绍启明星辰MAF大模型应用防火墙的防护思路。

vLLM是当前业界广泛应用的大模型推理与服务引擎,为众多AI应用提供底层技术支撑。作为核心基础设施,一旦出现安全漏洞,便可能带来严重后果。此次披露的CVE-2025-62164漏洞即属于内存损坏类型,直接威胁到托管vLLM的服务器安全。

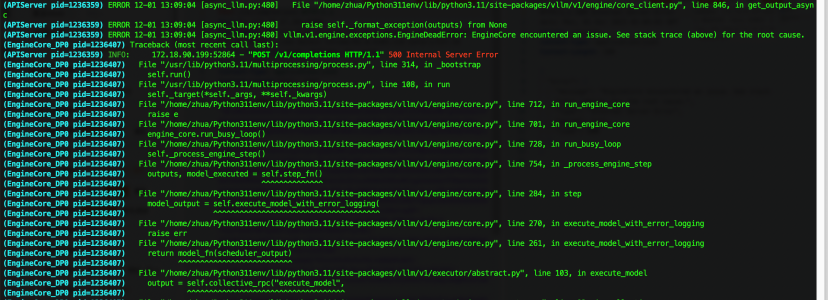

通过逆向分析vLLM源码,启明星辰还原了该漏洞的完整攻击链路:攻击者向/v1/completions接口发送精心构造的恶意请求,在HTTP Body中植入带有风险 prompt_embeds(提示嵌入)参数;vLLM后端接收该参数后,会调用torch.load()函数加载序列化的张量数据;由于底层依赖的PyTorch 2.8.0版本默认禁用了稀疏张量的完整性检查,恶意构造的序列化张量可轻松绕过边界检查;当程序调用to_dense()方法转换张量格式时,会触发越界内存写入,最终导致vLLM应用程序崩溃退出,引发拒绝服务攻击。

恶意请求导致vLLM内存崩溃

该漏洞反映了大模型供应链安全的普遍问题。据统计,大模型系统中约70%的代码来自外部供应链,包括开源组件、第三方库和预训练模型。攻击者可通过污染数据、篡改依赖或植入后门等方式,沿供应链渗透至核心系统,威胁贯穿数据、分发、训练、推理及应用全链路:

• 上游(数据层):面临网页数据抓取投毒、训练数据集污染、隐私泄露等风险。

• 中游(模型/框架层): 面临开发包投毒、反序列化、模型后门等风险。

• 下游(应用层):面临命令执行、SSRF、越权访问、沙箱逃逸等风险。

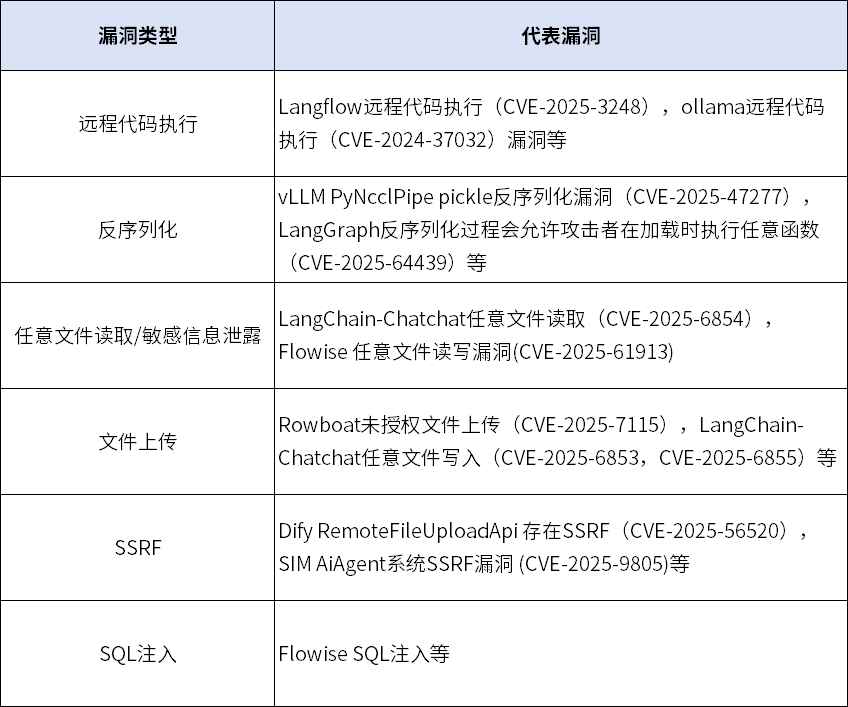

启明星辰目前已针对40+LLM供应链高危漏洞开展分析研究,覆盖LLM应用框架(如Dify的SSRF漏洞)、基础平台(如ollama的RCE漏洞)、代码IDE及智能体(如smolagents相关漏洞)等多类场景。这些漏洞分布于推理引擎、应用框架、API网关、智能体平台等关键组件,从底层vLLM推理服务,到上层Dify、Langflow应用框架,再到各类开发工具和智能体平台,均可能成为攻击者的目标。更值得警惕的是,这些组件往往存在相互调用、层层嵌套的关系,一个局部漏洞可能沿调用链传导,最终导致整个服务体系被击穿。

MAF破局LLM供应链安全

从单点防御到全生命周期防护

启明星辰MAF大模型应用防火墙部署于大模型服务或智能体服务入口,所有流向推理引擎、应用框架、API接口、智能体平台的请求均需经过MAF检测。该部署架构使MAF能够在统一位置覆盖vLLM、Dify、ollama、Langflow等各类LLM组件,实现“一点部署、全链防护”。

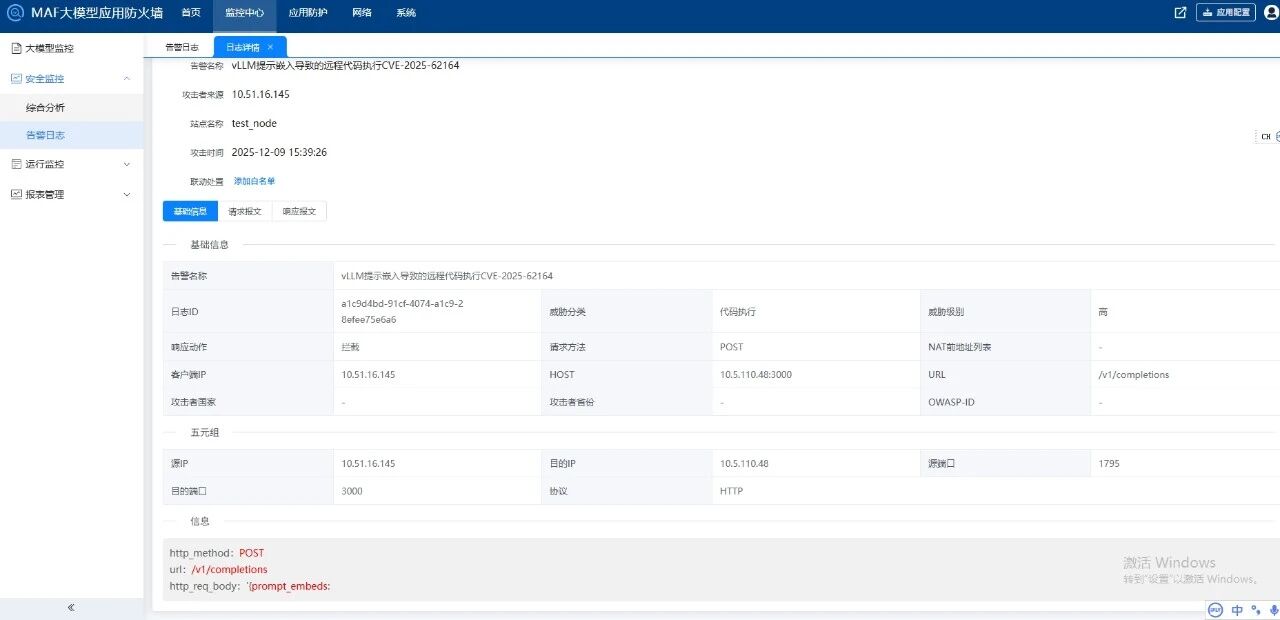

针对CVE-2025-62164漏洞,启明星辰MAF通过对大模型服务对话接口“/v1/completions”的请求数据进行针对性检测,可有效拦截恶意构造的prompt_embeds参数,防范该漏洞引发的vLLM服务崩溃问题。

MAF精准拦截vLLM RCE漏洞(CVE-2025-62164)

通过深度剖析Langflow、Ollama等多个高危供应链漏洞,启明星辰发现尽管AI供应链中下游框架和应用迭代速度较快,但其安全风险本质仍属于传统Web安全问题范畴,其中远程代码执行、反序列化、任意文件读取是出现频率最高的漏洞类型。具体如下表所示:

基于此洞察,启明星辰MAF不仅持续保持着对行业热点漏洞的敏锐嗅觉与快速响应能力,更致力于构建一套基于攻击原理的“算法免疫”体系。该体系继承了启明星辰WAF在传统安全领域的成熟检测能力,对命令注入、代码执行、SSRF等威胁具备完善的防护算法,并针对LLM场景完成了流量特征适配。因此,无论是vLLM的反序列化漏洞,还是Dify的SSRF攻击,只要攻击行为触发了底层恶意特征,即使在0-day漏洞爆发的窗口期,MAF也能实现准确识别与有效拦截。

AI时代的大模型安全防护,已延伸至供应链的每一个环节,vLLM高危漏洞的爆发表明,大模型安全防护必须突破“单点防御”局限,覆盖LLM全生命周期阶段。启明星辰MAF大模型应用防火墙凭借“一点部署、全链防护”的架构优势,以及基于攻击原理的算法防护能力,破解LLM供应链安全难题,确保每一个外部组件都经过严格安全校验,为企业智能交互提供坚实的安全保障。

京公网安备11010802024551号

京公网安备11010802024551号