AI+安全-启明星辰新一代安全防护体系核心 > 人工智能赋能安全技术介绍

大模型在下游安全领域任务中表现往往欠佳,通常被认为是既缺乏领域知识,也缺乏应用领域知识的方式。

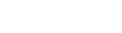

上图中,我们列举了现在主流的大模型调优技术。对于L1安全行业大模型,我们使用右半图的技术,通过更新模型参数来获得一个具备更强安全知识的大模型。而对于L2的应用场景层,我们则会使用左半图的技术,使大模型在实际场景中无需参数更新即可快速落地。

我们将这些技术区分为“注入知识”和“注入应用知识的方式”两种。直观来讲,前者(上半图)的主要目的是让大模型获得安全领域知识,能够在回答时有理有据而不是凭空捏造。而后者(下半图)的主要目的则是教会大模型应用知识,希望大模型的回答能够依循特定格式或特定思路;特别的,人类反馈强化学习是希望大模型能够对齐人类认知,在合理应用知识的同时,提升回答的可用性和安全性。

下面我们将分别介绍这些技术的应用方式和优缺点。

增量预训练

增量预训练(Continuous Pre-train,CPT)是一种常见的知识注入方式。它的思路是,大模型是通过学习大量通用知识得到的,那么我将领域知识和通用知识混合到一起,然后使用这些数据继续训练原有L0基础大模型。换而言之,增加了领域知识在训练数据中的比重,即增加了原有模型的领域知识。

这种思路显然是合理且有效的。增量预训练的缺点通常在于数据和算力成本。它不仅对算力的要求相对偏高,也需要大量精心清洗的领域知识数据。不过,它的优点是注入模型的数据不需要人工打标,也就是说,算法人员只需要对数据做去重、去广告等清洗工作,不需要逐条对数据做精细处理。因此,增量预训练所获取的数据通常可以有较大量级,注入的知识也较为全面。

有监督微调

有监督微调(Supervised Fine-tuning,SFT)是指基于已有的大模型,在有标注数据上进行模型训练。现有的SFT技术通常无需微调模型的所有参数,仅微调少量(或额外)模型参数,从而显著降低计算和部署成本,同时产生与全量微调模型相当的性能。通过这种方式,可以在消费级硬件上训练和存储大模型,让大模型适应各种下游应用。

有监督微调的缺点在于,用于微调大模型的数据通常需要极其精细化的清洗和逐条的人工打标,好在需求的数据量并不大,使用最低百条数据微调往往就能让大模型学会一些简单的思路与格式。

到这里,我们希望通过一个例子来更好的讲述上文提及的技术概念。在安全运营场景中,用户希望大模型对已知的安全事件进行解读,包括告警内容、事件类型、攻击手法、资产属性等。这样的应用场景需要这样完成:

1.首先,我们使用大量公开的网络安全与主机安全相关知识对大模型做增量预训练

2.其次,我们使用安全专家标注后的如下问答对,对我们的安全大模型进行有监督微调

{

"问题":用户提出的问题 + 已知事件信息 + 期望返回结果,

"回答":事件类型 + 攻击手法 ...

}

3.最后,就得到了我们可以在实际场景中使用的模型。

但是,对每一个下游任务进行微调显得过于复杂和冗余了。于是,我们引入了一些不需要更新模型参数的技术,它们同样能有优秀的使用效果。

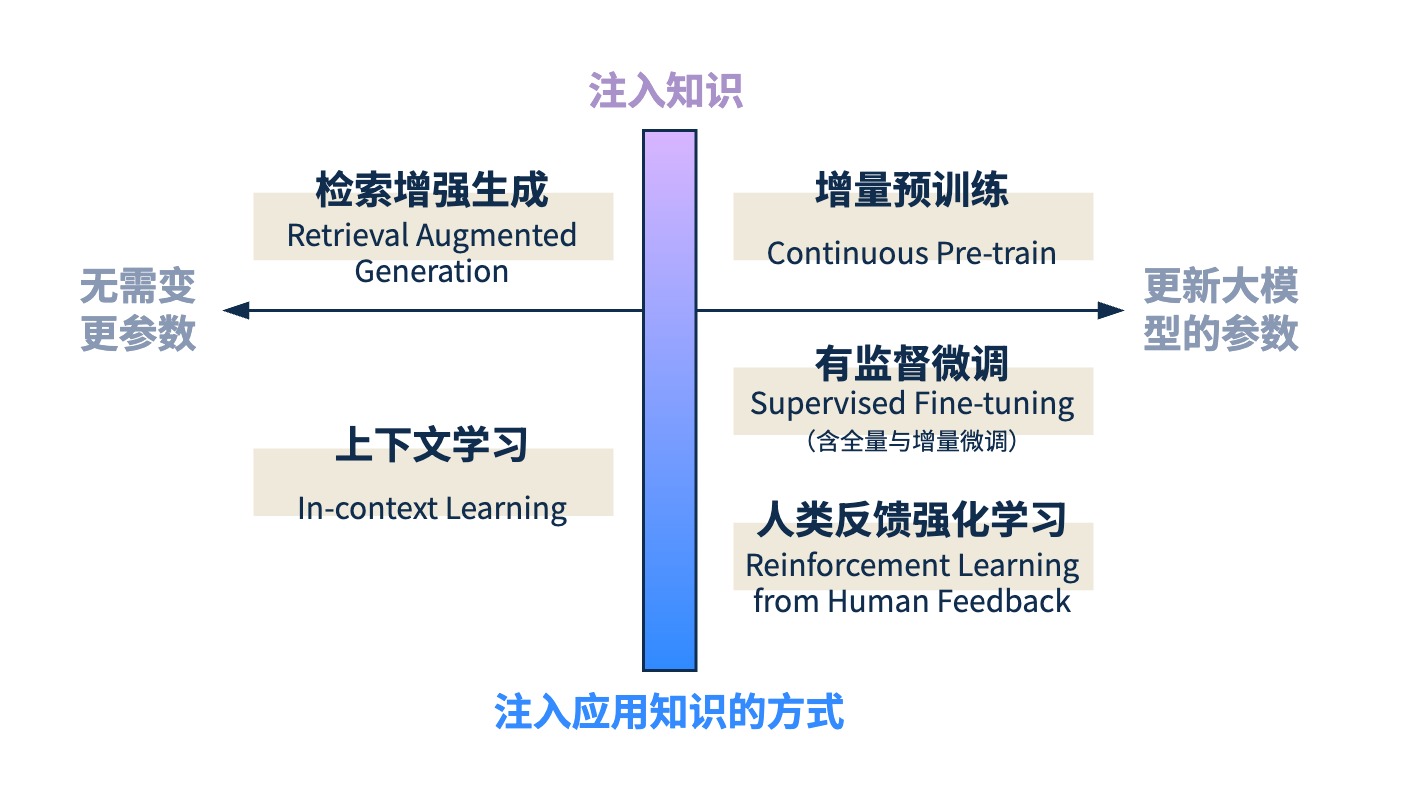

检索增强生成

检索增强生成(Retrieval Augmented Generation,RAG)是时下热门的大模型应用解决方案。它的主要原理是,用户提出问题,通过类似搜索引擎的方式从知识库中找到相关的知识片段,随后将用户的问题与搜索的结果一同输入给大模型,让大模型对着“参考答案”生成回答。

它的优点非常明显,相比于增量预训练,检索增强生成的成本更低,而且知识更新更快。缺点则是,检索增强生成对知识库的质量要求较高,要求最后得到的相关知识片段确实提供了回答用户问题所需要的知识,且能够被大模型顺利理解。幸运的是,使用增量预训练还是检索增强生成并不是一个单选题,实践中我们可以选择“我全都要”,即可同时享受两种技术的优点。

上下文学习

上下文学习(In-context Learning,ICL)是一种非常便利的方法。它只需要我们在给大模型输入问题时,对它给出一些“示范”性质的提示,即可让大模型按照示范来生成回答。通常使用上下文学习的用户问题格式如下所示。

上下文学习的优点是它的便利性,而缺点则是,对于复杂的问题,简单的提示往往很难起到良好的效果。

那么到这里,我们似乎可以不再对每一个下游任务都进行有监督微调,而是用更加灵活的方式完成上面的安全运营场景(对于和之前步骤不同的地方,我们做了加粗标注):

1.首先,我们使用大量公开的网络安全与主机安全相关知识对大模型做增量预训练

2.其次,我们使用安全专家标注后的多个不同安全任务场景下的问答对,对我们的安全大模型进行有监督微调

3.再次,我们对每个单独的下游任务,使用检索增强生成和上下文学习来进行单独的任务提示

4.得到最终生成的结果

实际应用场景中,大模型还需要通过人类反馈强化学习获得更好的安全性和可用性,我们将继续介绍这一技术。

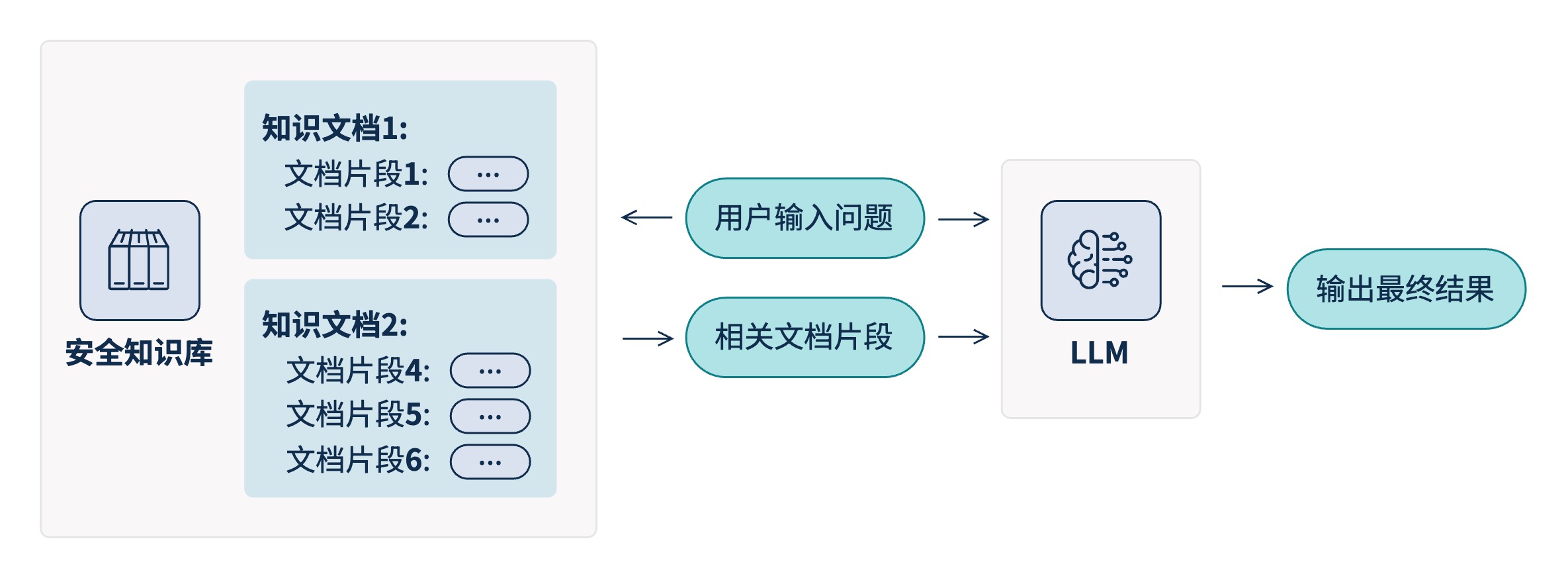

人类反馈强化学习

人类反馈强化学习(Reinforcement Learning from Human Feedback,RLHF)技术的主要目的是通过将人类的反馈纳入训练过程,为机器提供了一种自然的、人性化的互动学习过程。实践中,人类反馈强化学习往往被用于提升大模型的安全性和可用性,前者一般指用户询问不合法内容时大模型可以给出拒绝回答,后者则指大模型给出的回答能够切实帮助到用户。

值得注意的是,安全性和可用性之间存在着微妙的关系。一方面,过于严格的安全措施可能会限制模型的表达自由度,导致它不能充分展示自己的知识库来帮助用户;另一方面,若过分追求用户体验而不顾及内容审查,则可能使模型暴露于产生不当输出的风险之中。因此,在RLHF的应用过程中,必须找到两者之间的平衡点,以避免出现“顾此失彼”的情况。这要求开发者们精心设计奖励机制,并持续监控模型的表现,确保每一次迭代都能朝着既定的目标前进,即同时提高系统的安全性和用户体验质量。

总之,通过将人类反馈融入到强化学习的过程中,RLHF不仅促进了AI系统的自我优化,还使得这些系统能够更好地服务于人类社会,成为人们日常生活和工作中值得信赖的伙伴。

总结

本文介绍了几种大模型技术在网络安全领域的应用,包括增量预训练、有监督微调、人类反馈强化学习、上下文学习和检索增强生成。这些技术通过不同的方式为大模型注入知识,显著提升了网络安全系统的性能。

展望未来,这些大模型技术将为网络安全领域注入新的活力。它们不仅能够提高系统的检测和响应能力,还能主动预见和防御新型威胁。通过持续学习和优化,这些技术将使网络安全系统更加智能、高效,成为企业和个人在数字世界中的坚实后盾。

快速链接

快速链接

Copyright © 启明星辰 版权所有 京ICP备05032414号  京公网安备11010802024551号

京公网安备11010802024551号